La rápida evolución de la inteligencia artificial se considera inevitable, pero enfrenta desafíos significativos, especialmente en términos de consumo de energía. Esta preocupación es crítica, ya que el sector, conocido por su uso y demanda intensiva, necesita soluciones urgentes para evitar que este problema obstaculice su crecimiento.

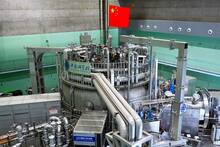

Sergey Edunov, director de ingeniería para IA Generativa en Meta, que lidera el entrenamiento de Llama 2 (el modelo de lenguaje de Meta) en una mesa redonda moderada por VentureBeat en Silicon Valley explicó que, según sus cálculos preliminares, la energía producida por dos nuevas centrales nucleares sería suficiente para satisfacer las necesidades energéticas de un año de uso de IA.

Edunov hizo hincapié en que su estimación se centra específicamente en la energía necesaria para la inferencia en IA, un proceso que permite a las aplicaciones de IA responder consultas y proporcionar recomendaciones.

Sólo para implementar la IA en aplicaciones

Esta distinción es crucial, ya que la inferencia generalmente requiere menos energía que el entrenamiento de modelos de IA, que implica procesar grandes cantidades de datos. La inferencia es una parte integral del uso práctico de la IA, lo que sugiere que, con una planificación energética adecuada, las demandas de energía de la IA podrían mantenerse bajo control.

Es por eso que el consumo excesivo de energía asociado a la fase durante la fase de entrenamiento de modelos como el GPT-4, representa un desafío ambiental y de sostenibilidad significativo. Estudios, como uno de la Universidad de Cornell, sugieren que el entrenamiento de modelos como el ChatGPT-3 puede ser extremadamente intensivo en recursos, comparando su consumo de energía con el uso anual de agua de todos los centros de datos de Microsoft en EE. UU. Destacando que por cada conversación, el modelo de lenguaje grande (LLM) se 'bebe' medio litro de agua de media.

Esta alta demanda energética plantea cuestiones críticas sobre la viabilidad a largo plazo de la IA generativa, especialmente en un contexto de creciente conciencia ambiental y necesidad de soluciones energéticas sostenibles. Aunque la inferencia parece ser sostenible en términos de consumo de energía, el entrenamiento de modelos como GPT-4, que potencialmente se entrenó con datos de todo Internet, representa un desafío más significativo.

Edunov señala además que los modelos de próxima generación podrían necesitar aún más datos para mejorar su rendimiento. Sin embargo, se están explorando técnicas de eficiencia y fuentes alternativas de datos, como los multimodales, para abordar estos desafíos, lo que subraya la importancia continua de la innovación en este campo.