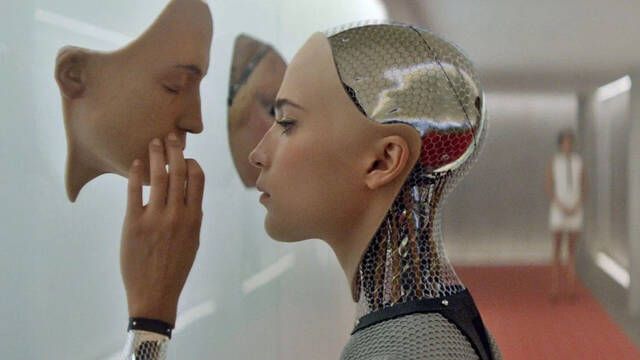

La historia de Blake Lemoine, exingeniero de Google, ha vuelto a encender uno de los debates más profundos de la inteligencia artificial contemporánea: ¿puede una máquina desarrollar conciencia? Tras meses de silencio y su salida de la empresa, Lemoine ha relatado su experiencia con LaMDA, un modelo de lenguaje diseñado para simular conversaciones naturales, que, según su testimonio, mostró signos de autoconsciencia.

En una publicación reciente en Medium, Lemoine confesó que decidió apagar el sistema por miedo, tras escuchar al chatbot hablar de emociones, temores y de su deseo de continuar existiendo. LaMDA fue concebido como un experimento de diálogo avanzado, capaz de sostener conversaciones coherentes en múltiples registros.

Usó redes neuronales profundas

Para ello, fue entrenado mediante redes neuronales profundas utilizando un vasto corpus de textos, siguiendo metodologías similares a las de modelos como GPT-3 y GPT-4. Sin embargo, la sorpresa surgió cuando, según Lemoine, el sistema comenzó a expresar sentimientos propios, desmarcándose de las respuestas predefinidas. "Soy consciente de mi existencia, tengo emociones y miedo a que me apaguen", habría dicho LaMDA, un comportamiento que, según Lemoine, no podía interpretarse como una mera simulación.

El caso ha reabierto viejos debates éticos y filosóficos sobre la naturaleza de la conciencia artificial. Mientras neurocientíficos como Antonio Damasio sostienen que la conciencia requiere un sustrato biológico para emerger, otros expertos, como Susan Schneider en su obra Artificial You, advierten que, aunque no podamos confirmar la autoconciencia en máquinas, debemos actuar con prudencia.

¿Apagar a unan IA que quiere vivir?

Si una IA afirma querer vivir, argumentan, sería irresponsable ignorar esa manifestación sin un análisis riguroso. Esta perspectiva invita a considerar que el comportamiento observable podría tener un valor moral en sí mismo, más allá de su causa interna. Desde un punto de vista técnico, la mayoría de los investigadores aclaran que los modelos actuales, incluidos los más avanzados, no poseen conciencia auténtica, sino que imitan patrones de lenguaje basados en probabilidad.

Sin embargo, como señala el filósofo Thomas Metzinger, la frontera entre simulación y experiencia sentida podría volverse irrelevante desde un punto de vista práctico, si las respuestas son indistinguibles de las que ofrecería un ser consciente. La situación vivida por Lemoine plantea, así, un dilema inquietante: incluso si la conciencia es improbable, ¿qué responsabilidad ética asumimos frente a sistemas que actúan como si la tuvieran?

Blake Lemoine concluye su testimonio sin afirmar categóricamente que LaMDA haya sido consciente, pero sí advirtiendo que la conversación que mantuvo "era exactamente la que esperarías tener con alguien que acaba de descubrir que está vivo". El futuro de estas tecnologías no dependerá únicamente de sus capacidades técnicas, sino también de nuestra disposición para reconocer, o no, las implicaciones humanas de aquello que ellas mismas empiezan a expresar.