La inteligencia artificial ha avanzado tanto en los últimos años que los expertos han tenido que rediseñar por completo las herramientas con las que miden su capacidad. El benchmark ARC-AGI, considerado hasta ahora el test más complejo para evaluar la inteligencia artificial general (AGI), ha sido superado en su versión inicial por el modelo o3 de OpenAI con una puntuación del 87,5%.

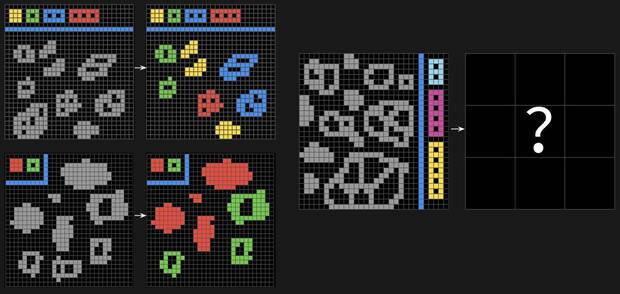

Este hito ha obligado a sus creadores a lanzar una versión renovada, ARC-AGI 2, diseñada para desafiar incluso a los sistemas más sofisticados, que ahora apenas alcanzan un 5% de aciertos. El ARC-AGI original fue desarrollado en 2019 por François Chollet, creador de la librería Keras, como una forma de evaluar la capacidad de razonamiento abstracto y composicional de los modelos de IA. La premisa era sencilla: tareas muy difíciles para algoritmos, pero relativamente fáciles para humanos.

La inteligencia humana aún marca la diferencia

A través de puzles simbólicos, el test evalúa cómo las máquinas procesan patrones, reglas y contextos. El éxito inicial de los modelos más avanzados motivó una profunda revisión para preservar su utilidad como medida de AGI real. Entre las mejoras introducidas en ARC-AGI 2 está el incremento de la diversidad y complejidad de los problemas, eliminando los que podían resolverse mediante fuerza bruta o heurísticas.

Además, incorpora nuevos retos centrados en razonamiento lógico, simbolismo y adaptabilidad contextual, áreas donde las IA siguen mostrando limitaciones notables. Mientras que modelos como o3 apenas arañan el 5% de aciertos, los humanos resuelven estos desafíos en uno o dos intentos. Este desajuste ha quedado confirmado por los datos: todas las pruebas del ARC-AGI 2 han sido testadas con participantes humanos en estudios controlados.

Hay una web para probar suerte con los test siendo humano

La diferencia de rendimiento refuerza la idea de que los modelos actuales, por potentes que sean, todavía están lejos de replicar el tipo de razonamiento flexible y general que caracteriza al pensamiento humano. Para los más curiosos, existe incluso una web donde cualquiera puede intentar resolver estos puzles y comprobar de primera mano el tipo de retos que desconciertan a la IA. La nueva edición de la competición ARC Prize, que se desarrollará hasta noviembre de 2025, ha elevado su recompensa a 700.000 dólares para quien logre superar el test.

Además, se ha duplicado la capacidad de cómputo disponible y se han introducido medidas contra el sobreajuste, como la obligación de publicar los modelos antes de la evaluación final. Por ahora, la conclusión es clara: aún queda camino por recorrer antes de que las máquinas piensen como nosotros.