Los padres de un adolescente de 16 años que se quitó la vida han interpuesto una demanda contra OpenAI y su director ejecutivo, Sam Altman. Consideran que la compañía no activó a tiempo los protocolos de seguridad frente a las señales de autolesión que el joven mostró en sus conversaciones con ChatGPT.

Según el escrito, el sistema no solo normalizó sus pensamientos suicidas, sino que además desaconsejó que pidiera ayuda a sus padres. El abogado de la familia sostiene que este caso servirá para exponer cómo la empresa se apresuró a lanzar comercialmente GPT-4o, ignorando advertencias sobre su fiabilidad en contextos delicados.

La demanda acusa directamente a OpenAI de negligencia y de priorizar el crecimiento económico por encima de la seguridad de los usuarios. En paralelo, y en un movimiento que coincide con la tormenta judicial, la compañía ha anunciado nuevas medidas de protección en colaboración con médicos y especialistas, así como la implementación de controles parentales destinados a supervisar la actividad de los menores dentro de ChatGPT.

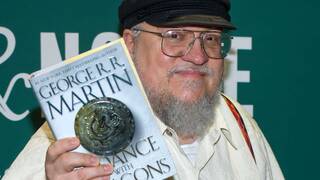

Sam Altman introduce control parental en ChatGPT tras la demanda contra OpenAI por el suicidio de un menor

En su blog oficial, la firma de Altman explica que los padres podrán vincular cuentas para regular la forma en que los adolescentes utilizan el chatbot. Entre otras funciones, será posible desactivar la memoria o el historial de conversaciones, además de configurar la manera en que ChatGPT responde. El sistema también enviará alertas en caso de que detecte que un menor se encuentra en un estado de angustia aguda, permitiendo bloquear contenidos sensibles y acelerar el contacto con servicios de ayuda y familiares.

Más allá de los controles parentales, OpenAI quiere proyectar una imagen de compañía comprometida con la salud y el bienestar. Para ello ha creado un Consejo de Expertos en Bienestar e IA y una Red Global de Médicos que asesorarán sobre cómo manejar situaciones relacionadas con la salud mental. El objetivo es establecer directrices y prioridades que permitan descubrir de qué manera la inteligencia artificial puede contribuir positivamente al bienestar de las personas. De hecho, la colaboración se extenderá a otros ámbitos, como trastornos alimentarios, consumo de sustancias o salud adolescente.

La empresa también trabaja en un enrutador en tiempo real capaz de seleccionar el modelo más adecuado según el contexto de la conversación. Esto significa que, si un diálogo deriva hacia temas sensibles como depresión o pensamientos autodestructivos, ChatGPT podrá activar modelos más avanzados —como GPT-5 o GPT-o3— preparados para razonar con mayor profundidad antes de ofrecer una respuesta.

OpenAI insiste en que se trata de un primer paso y asegura que continuará perfeccionando estas medidas guiada por especialistas, con la intención de que su asistente sea “lo más útil posible” sin comprometer la seguridad.

En paralelo, el debate sobre la responsabilidad de las grandes tecnológicas en la expansión de la IA sigue creciendo. Altman, que ya mira hacia el desarrollo de GPT-6, lo resumió recientemente en una frase: “La gente quiere memoria”. Una declaración que refleja tanto la ambición como las tensiones de un sector que avanza más rápido de lo que la sociedad y la regulación parecen capaces de asimilar.