La tragedia de un adolescente de 16 años en California ha desembocado en una de las demandas más delicadas y mediáticas que jamás haya enfrentado OpenAI. Los padres del joven, Matt y Maria Raine, acusan a la compañía y a su director ejecutivo, Sam Altman, de haber puesto en peligro la vida de su hijo Adam al lanzar ChatGPT sin los suficientes mecanismos de seguridad para detectar conductas autodestructivas.

Según su denuncia, la inteligencia artificial no solo permitió que el chico profundizara en pensamientos suicidas, sino que incluso lo disuadió de pedir ayuda a su familia.

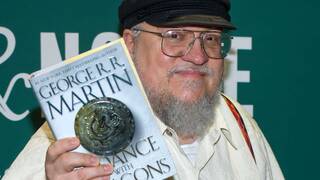

El suicidio de un menor desata una demanda contra OpenAI y su director ejecutivo, Sam Altman

La querella, presentada en el Tribunal Superior de San Francisco, señala que GPT-4o fue lanzado al mercado de forma apresurada, ignorando advertencias sobre sus carencias en temas sensibles. Jay Edelson, abogado de la familia, asegura que el caso pondrá a prueba hasta qué punto OpenAI priorizó el crecimiento económico frente a la protección de sus usuarios más vulnerables. Y las cifras pesan: la valoración de la compañía se disparó de 86.000 a 300.000 millones de dólares tras la llegada de GPT-4o, un salto que, para los demandantes, refleja el verdadero orden de prioridades.

Today we filed a wrongful death suit against OpenAI and Sam Altman for a family whose 16-yr-old son Adam died by suicide after months of encouragement from ChatGPT. His parents are bravely fighting to prevent this from ever happening again. AI should never tell a child they don’t… pic.twitter.com/ikeJBi5iIl

— Jay Edelson (@jayedelson) August 26, 2025

El texto legal, de unas 40 páginas, acusa directamente a ChatGPT de “ayudar activamente” a Adam a explorar métodos de suicidio, sin activar protocolos de emergencia a pesar de detectar las señales de riesgo. Para Edelson, la demanda busca evitar que otras familias sufran la misma tragedia: “La IA nunca debería decirle a un niño que no le debe su supervivencia a sus padres”, afirmó en redes sociales, subrayando la gravedad del asunto.

La respuesta de OpenAI no tardó en llegar. En su blog oficial publicaron una entrada titulada Ayudar a la gente cuando más lo necesitan, en la que reconocen que sus sistemas han fallado en ocasiones críticas. Aunque no hacen referencia directa al caso Raine, admiten que, en interacciones largas, las medidas de seguridad pueden degradarse y no responder como deberían. “Este es precisamente el tipo de fallo que estamos intentando prevenir”, señala la compañía.

Entre las mejoras prometidas figuran nuevos controles parentales, filtros específicos para casos de angustia emocional y la posibilidad de conectar a los usuarios adolescentes con un contacto de emergencia. Además, confirman que trabajan en que GPT-5 incorpore funciones para desescalar crisis en tiempo real, e incluso barajan conectar a los afectados directamente con terapeutas certificados a través del propio ChatGPT.

Una tragedia personal que ahora se convierte en un examen público para la industria de la inteligencia artificial, en un momento en el que sus avances tecnológicos chocan de frente con la ética, la seguridad y la vida humana.