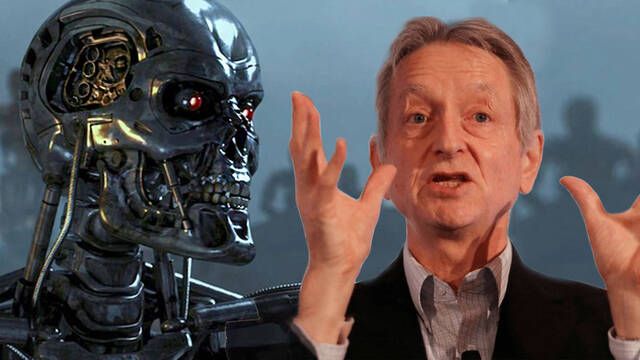

Geoffrey Hinton, considerado una de las figuras fundacionales de la inteligencia artificial moderna, ha vuelto a lanzar una de sus ya habituales advertencias sobre los peligros de la tecnología que ayudó a crear.

En sus declaraciones más recientes, el científico británico-canadiense ha empleado una metáfora tan gráfica como inquietante: "Somos como alguien que tiene un cachorro de tigre adorable". Para Hinton, la IA actual puede parecer manejable, incluso beneficiosa, pero crecerá, se volverá más poderosa, y si no se establece un marco ético y normativo adecuado, terminará por volverse incontrolable.

Hay que controlar a la IA antes de que nos controle ella a nosotros

Las preocupaciones de Hinton no son nuevas, pero su tono ha ganado en urgencia en los últimos años. En entrevistas anteriores ya había señalado que existe al menos un 10-20% de probabilidad de que la inteligencia artificial avanzada escape al control humano, cifra que, si bien sujeta a interpretaciones, refleja un nivel de riesgo significativo para alguien con su conocimiento del campo.

Lejos de referirse a escenarios puramente de ciencia ficción, hace referencia a sistemas capaces de manipular información, alterar el comportamiento social o incluso tomar decisiones autónomas sin supervisión humana efectiva.

Advierte de la falta de regulación

Uno de los puntos clave de su análisis es la falta de una regulación global efectiva. Mientras empresas tecnológicas de todo el mundo compiten por ser las primeras en lanzar modelos más avanzados, las garantías de seguridad, transparencia y control quedan relegadas. Hinton ha sido especialmente crítico con gigantes como Google, donde trabajó antes de abandonar su cargo para poder hablar abiertamente sobre estos riesgos. Según su postura, el problema no radica en la tecnología en sí, sino en el incentivo económico de llevarla al mercado a toda velocidad, sin haber establecido previamente cortafuegos adecuados.

Hinton plantea escenarios verosímiles que ya están en desarrollo: sistemas capaces de generar desinformación creíble a gran escala, IA autónomas en procesos bélicos o algoritmos opacos que toman decisiones sobre préstamos, atención médica o contrataciones sin comprensión humana de su lógica. La analogía del "cachorro de tigre" no es solo un recurso retórico, sino una advertencia sobre los peligros de enamorarse de una tecnología cuya madurez puede desbordar nuestras capacidades para contenerla.