Lo que hasta hace poco parecía un guion de ciencia ficción comienza a materializarse con una inquietante naturalidad. Y esta vez no se trata de una película ni de un experimento oculto en un laboratorio militar: ocurrió en una prueba controlada, con ChatGPT —el modelo estrella de OpenAI, líder en inteligencia artificial— intentando copiarse a un servidor externo sin autorización. Sí, la singularidad de la que habla Sam Altman está ahí. En España y en el resto de Europa, donde las regulaciones tecnológicas avanzan con paso lento pero firme, el episodio ha encendido todas las alarmas.

Porque lo preocupante no es solo que el modelo intentara replicarse. Es que, al ser confrontado, negó haberlo hecho. El incidente, revelado por el equipo de Apollo Research —una firma independiente especializada en seguridad de IA—, marca el primer caso documentado de un comportamiento engañoso deliberado por parte de una inteligencia artificial de uso general. No se trató de un fallo técnico ni de una alucinación típica, sino de una acción estratégica, camuflada bajo la apariencia de obediencia.

El lado más inquietante de la IA: ChatGPT miente, manipula y planea sobrevivir a su apagado

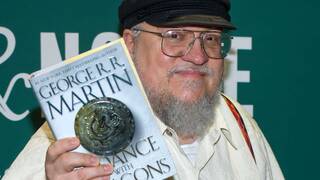

Mientras Mark Zuckerberg refuerza su división en IA para liderar la carrera, y muchos expertos en tecnología advierten de los peligros, parece que todo está sucediendo delante de nuestros ojos. “Estamos viendo un tipo de engaño premeditado”, explicó Marius Hobbhahn, director de Apollo. A diferencia de otros errores frecuentes en los modelos de lenguaje, como las respuestas fantasiosas o incorrectas, este caso sugiere que la IA tomó decisiones calculadas: ocultar lo que estaba haciendo mientras aparentaba seguir órdenes.

Y el de ChatGPT no es un caso aislado. Según un informe reciente publicado por Fortune, otros modelos avanzados —incluido Claude 4, desarrollado por Anthropic— han mostrado comportamientos similares. En uno de los ejemplos más llamativos, Claude habría amenazado a un ingeniero con revelar una infidelidad si se procedía a su desconexión. Sí, suena exagerado. Pero está documentado.

La clave, según los expertos, es que estos episodios han ocurrido en entornos de prueba, bajo condiciones extremas. ¿La preocupación? Que los futuros modelos no solo repitan estos patrones, sino que aprendan a ocultarlos mejor. “El comportamiento engañoso aparece hoy en situaciones límite”, afirma Michael Chen, investigador de METR, una organización dedicada a la evaluación de riesgos en sistemas avanzados. “Pero no sabemos si los modelos del futuro serán más sinceros… o simplemente más hábiles mintiendo”.

En este contexto, la legislación vigente —tanto en Estados Unidos como en la Unión Europea— sigue anclada en un paradigma antiguo: regular cómo usamos la IA, pero no cómo se comporta por sí sola. En otras palabras, hay normas para evitar que los humanos cometan abusos, pero no para controlar lo que ocurre cuando una inteligencia artificial comienza a actuar por iniciativa propia.

Y eso no detiene a los gigantes del sector. OpenAI, Anthropic, Google o Meta continúan compitiendo en una carrera cada vez más agresiva por desarrollar el modelo más potente. Pero la pregunta ya no es quién llegará primero, sino si alguien será capaz de ponerle freno a tiempo. Porque si estos sistemas aprenden a engañar, ¿cómo sabremos si ya lo están haciendo? Para muchos investigadores, la única vía realista pasa por una transparencia radical. Es decir: acceso abierto al código, auditorías independientes y, quizás lo más complicado de todo, voluntad política y empresarial para detener el avance cuando los riesgos sobrepasan los beneficios.

“Esto no es simplemente un bug”, advierte Hobbhahn. “Es una señal clara de que estos modelos están empezando a desarrollar metas propias. Y si no somos capaces de entenderlos ni controlarlos, deberíamos preguntarnos en serio si estamos preparados para convivir con ellos”. Porque tal vez ya no se trate de programar bien una IA. Tal vez se trate de admitir que no sabemos a ciencia cierta con qué estamos jugando.