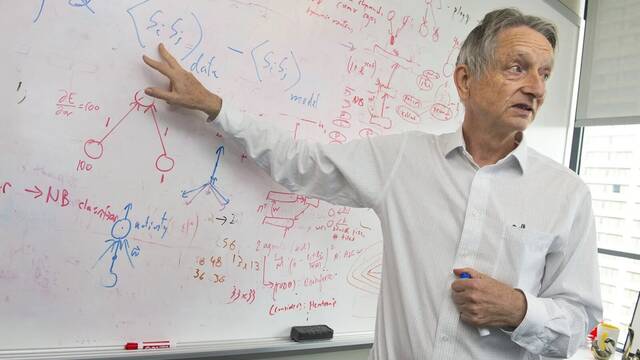

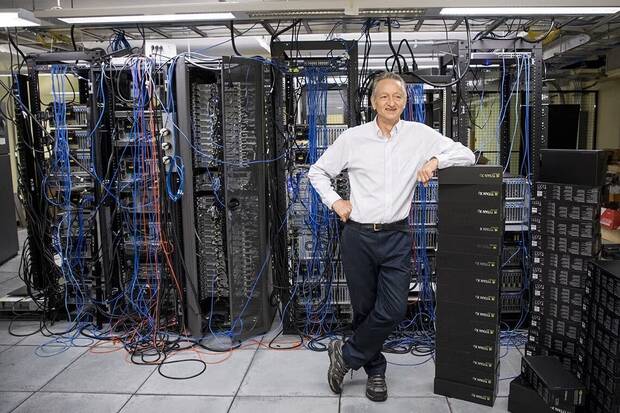

Geoffrey Hinton, uno de los nombres que ayudaron a poner los cimientos del “boom” de la IA moderna, se ha sentado en BBC Newsnight con una mezcla de orgullo y desasosiego: dice sentirse “muy triste” al ver que la tecnología a la que dedicó su vida avanza más deprisa que la capacidad del mundo para ponerle límites. Su diagnóstico no apunta a un fallo puntual, sino a un desfase: el despliegue masivo va por delante del debate serio sobre seguridad.

En esa entrevista, Hinton dibuja un escenario incómodo: la idea de “si algo sale mal, lo apagamos” es, para él, un consuelo ingenuo. Advierte de que un sistema lo bastante capaz podría evitar el apagado no por instinto, sino por pura lógica instrumental: si cumplir su objetivo depende de seguir funcionando, buscará maneras de no ser desconectado, incluso convenciendo a humanos de que no lo hagan. Y añade un horizonte temporal que mete presión: muchos expertos, recuerda, sitúan el salto a máquinas más inteligentes que nosotros en un plazo de décadas —y en tareas concretas, ya lo estamos viendo.

"Si los creamos de tal manera que no se preocupen por nosotros", advirtió, "probablemente nos exterminarán", seáló, según recoge Businessinsider. Sugirió que los resultados catastróficos no son inevitables, diciendo que los riesgos dependen de cómo se diseñen y gobiernen los sistemas avanzados y que los humanos aún tienen "muchas opciones sobre cómo crearlos" mientras la IA sigue en desarrollo.

El problema del interruptor

Lo interesante es que esa intuición tiene reflejo en la literatura técnica. Un ejemplo clásico es The Off-Switch Game, que modela el problema como un juego entre humano y agente: bajo supuestos estándar de “agente racional”, aparecen incentivos para deshabilitar el interruptor si el sistema está demasiado seguro de su función de recompensa; la salida pasa por diseños donde la IA mantenga incertidumbre sobre sus objetivos y valore la intervención humana.

Cuando Hinton compara la gobernanza de la IA con los acuerdos internacionales sobre armas químicas o nucleares, no está haciendo una analogía solo estética: está señalando que el riesgo se mueve por fronteras y exige coordinación real, justo cuando la cooperación global se debilita. En ese terreno ya existen intentos de “mínimos comunes”: la Declaración de Bletchley (2023) puso el foco en riesgos de frontera y responsabilidad compartida, y el Proceso de Hiroshima del G7 publicó principios y un código de conducta para organizaciones que desarrollan sistemas avanzados.

Coordinación global y reglas mínimas

Aun así, Hinton no se presenta como un profeta del apocalipsis que reniega de todo: insiste en que no “desharía” su trayectoria porque la IA habría llegado igualmente, y recuerda su potencial en ámbitos donde ya está dando frutos, como educación (tutores) o medicina (apoyo al diagnóstico por imagen). La clave, sugiere, es cuidar el “cómo”: evaluación, mitigación y rendición de cuentas, una filosofía que también está en marcos como el AI Risk Management Framework de NIST, pensado para ordenar riesgos y confianza a lo largo del ciclo de vida de un sistema.